현재 데이터 파이프라인은 갈수록 대규모화 되고 있으며, 이를 처리하는 핵심 기술로 Apache Spark가 널리 사용되고 있다.

하지만 Spark의 대규모 분산 처리 구조는 복잡한 구성과 성능 이슈 해결 측면에서 많은 시간과 전문 지식을 요구한다.

특히, Spark에서 파이프라인 실패나 지연 시 그 원인을 파악하려면 로그, Spark History Server UI, 모니터링 툴 등 다양한 인터페이스를 오가며 수동으로 진단해야 한다.

Spark의 작업이 실패할 경우 보통 아래와 같은 트러블 슈팅 과정을 거치게 된다.

- Spark History Server UI 접속

- Jobs, Stages, Tasks 탭 전환하며 분석

- Driver와 각 Executor 로그 확인

- 메모리/CPU 등의 메트릭 패턴은 별도의 모니터링 도구(Grafana 등)에서 확인

- Stack Overflow, AI 툴 등을 통한 검색

- 해결책 도출 및 적용

하지만 위 과정을 통해서 AWS가 지적한 3가지의 문제는 아래와 같다.

Complex connectivity and configuration options to a variety of resources with Spark- Spark는 다양한 리소스와 연결되어 있으며, 그로 인해 설정이 최적화되지 않거나 올바르게 구성되지 않았을 때 실패의 근본 원인을 찾기가 어렵다.

Spark's in-memory processing model and distributed partitioning of datasets across its workers- 인메모리 처리와 분산처리를 진행하기에 각 워커의 리소스가 파편화되어 병목 구간을 쉽게 확인하기 어렵다.

Lazy evaluation of Spark transformations- 실행 계획이 복잡하고 로그 상의 연관성이 명확하지 않아 디버깅에 시간과 노력이 많이 든다.

디버깅하는데 정보들이 파편화되어 있어서 분석 효율이 저하되며, Spark는 분산처리를 하기 때문에 동일한 문제에 대해서 재현이 어렵고 병목 구간에 대해 쉽게 확인하기 어렵다.

Spark History Server는 문제 해결을 위한 거의 모든 정보를 제공하지만, 어떤 정보가 문제 해결에 필요한지는 알려주지 않기 때문에 엔지니어의 경험과 직관에 크게 의존하게 된다.

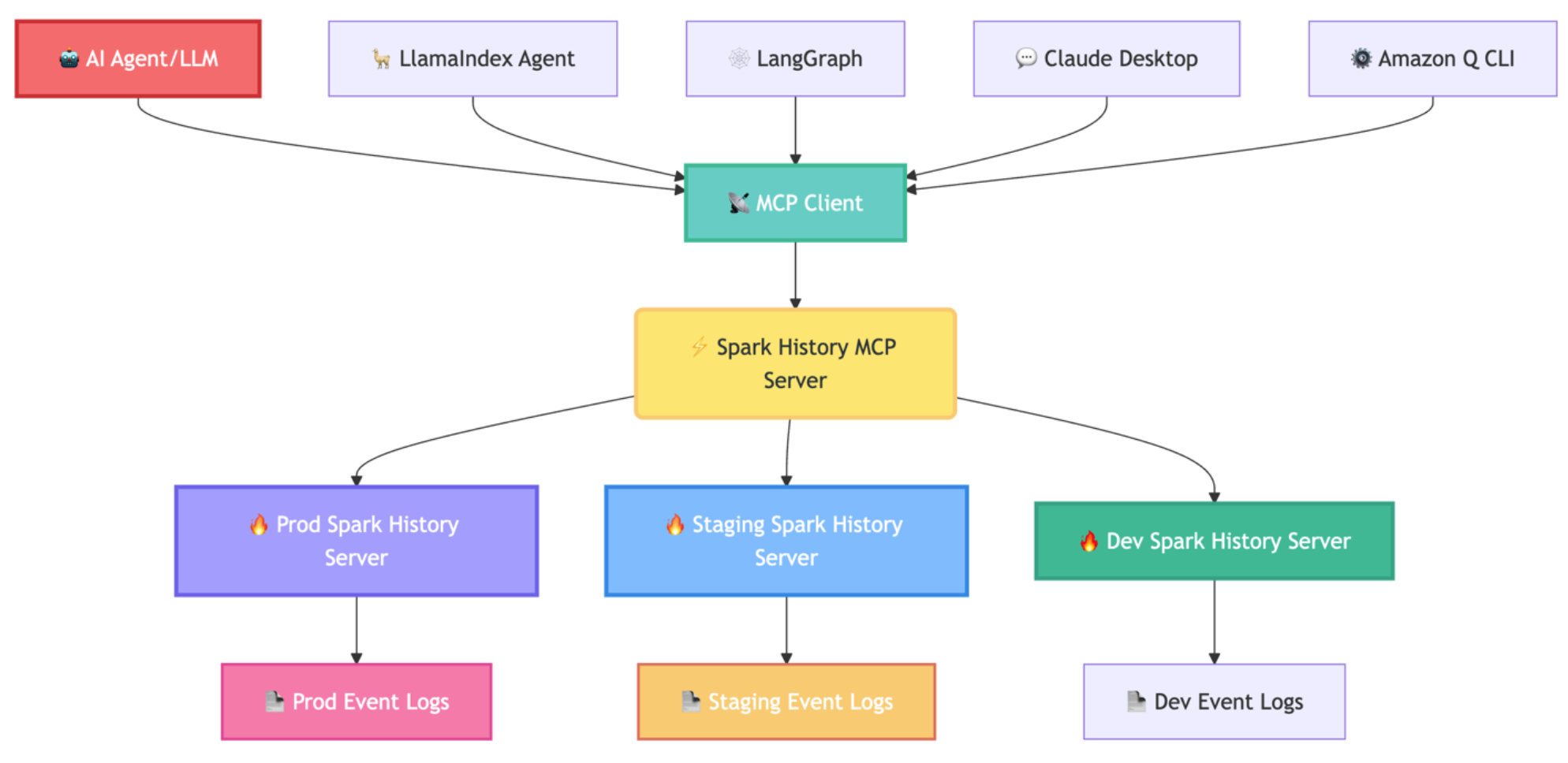

이러한 한계를 해결하고자 AWS 에서는 Apache Spark History Server 데이터를 AI 기반으로 분석하고 디버깅할 수 있는 MCP 기능을 오픈소스로 제공하기 시작했다.

이 글에서는 Spark 디버깅의 자동화를 가능하게 해주는 MCP 서버에 대해 살펴보고,

이를 현재 업무에 적용이 가능한지와 적용했을 때의 어떤 이점이 있는지 확인할 예정이다.

1. 왜 MCP 가 필요할까?

Model Context Protocol 는 Anthropic에서 발표한 프로토콜로 AI 와 외부 데이터 소스 및 도구들 간의 원활한 통합을 가능하게 하는 개방형 프로토콜이다.

기존 AI 만을 사용했을 때의 한계는 특정 시스템에 대한 기술정보 접근이 불가하여

실제 운영 데이터가 아닌 일반적인 권장사항을 제공했다.

MCP 활성화한 AI는 실제 운영 데이터 기반 인사이트를 제공이 가능하기 때문에

일반적인 모범 사례가 아닌 실제 운영 데이터 기반으로 분석하여 디버깅 또는 최적화를 해줄 수 있게 된다.

여러가지 사례를 살펴보자.

1-1) 간헐적 DB Connection 실패

최근 변경사항이 없는 Spark 배치에서 간헐적으로 아래와 같은 에러가 발생하였다.

해당 배치는 DocumentDB 를 조회하여 처리하는 배치이며, 실패를 하더라도 Airflow 에서 재시도를 하게 되면

정상적으로 실행 되었다.

간헐적으로 실패가 발생하는 점과 아래 에러 로그만 봤을 때 DB Connection Pool 및 Timeout 설정을 점검하고

변경하는 것으로 문제 해결을 시도했다.

java.sql.SQLException: Communications link failure

sun.reflect.DelegatingConstructorAccessorImpl.newInstance(DelegatingConstructorAccessorImpl.java:45)

Caused by: java.net.SocketTimeoutException: connect timed out

하지만, 설정 변경으로 해결되지 않았고 실패한 Job 들의 executor IP 대역이 동일하다는 패턴을

확인하고서야 네트워크 설정 문제임을 확인했다.

최근에 인프라팀에서 새로운 subnet 대역이 추가되었고, 새로운 subnet 에서 DocumentDB로의 NACL outbound 트래픽이 차단되어 있음을 확인했다.

재시도 시 Spark가 정상적인 subnet에 할당 되어 성공했었다.

위 상황에서 MCP 가 구성되어 있었다면 빠르게 원인 파악이 되지 않았을까?

최근 실패한 Job들과 성공한 Job들을 비교하여 실패 원인을 분석해줘.

1-2) spark.sql.files.maxPartitionBytes 증가와 함정

spark.sql.files.maxPartitionBytes 는 Spark가 파일을 읽을 때 하나의 파티션에 할당할 수 있는

최대 바이트 수를 정의한다.

기본값은 128MB이며, 이 값을 조정하여 Task 수와 병렬 처리량을 제어할 수 있다.

많은 문서에서 해당 설정만으로 파일을 읽을 때 파티션의 크기를 결정할 수 있을 것처럼 설명하지만 아래 설정과 함께 봐야 한다.

- spark.sql.files.openCostInBytes (default: 4MB)

- spark.sql.files.minPartitionNum (default: spark.default.parallelism)

아래 코드를 확인해보면, spark.sql.files.maxPartitionBytes 설정만으로 파일을 읽을 때 파티션의 크기가 의도대로 조절되지 않을 수 있음을 알 수 있다.

maxSplitBytes = Math.min(

defaultMaxSplitBytes, // spark.sql.files.maxPartitionBytes

Math.max(

openCostInBytes, // spark.sql.files.openCostInBytes

bytesPerCore // totalBytes / minPartitionNum

)

)

spark.sql.files.minPartitionNum 을 설정하지 않으면 spark.default.parallelism(default: executor 갯수 x core 갯수) 설정을 바라보게 되고, 해당 값은 실제 운영 환경 마다 다르다.

1-3) spark.memory.fraction 증가와 함정

spark.memory.fraction은 Spark Executor의 전체 힙 메모리 중에서 execution과 storage에

사용할 수 있는 메모리 비율을 정의한다.

기본 값은 0.6 이며, 이 값을 조정하여 Spark 작업의 메모리 효율성을

제어할 수 있다.

많은 문서에서 Out Of Memory 문제를 해결하기 위한 방법으로 해당 설정 증가를 권장하지만 상황에 따라 역효과가 발생할 수 있다.

문제가 되는 메모리가 어떤 영역인지를 정확히 파악이 되어야 하며, 만약 UDF를 주로 사용한다면 오히려 문제가 더 심해질 수 있다.

UDF 등은 memory.faction 영역이 아닌 user memory 영역에서 관리되기 때문이다.

위의 사례에서 처럼 일반적인 Best Practice가 어느 상황에서는 역효과가 발생할 수 있다.

따라서, 현재 업무의 상황과 환경에 맞게 분석하여 솔루션을 제공하는 것이 해당 오픈 소스를 사용하는

이유이다.

즉, 기존처럼 UI를 탐색하지 않아도 자연어로 spark-abcd 잡이 왜 실패했는가? 라고 묻는 것만으로도 AI가

로그, 실행 시간, 리소스 소비 내역 등을 종합 분석해 근본 원인을 알려준다.

설정 변경 없이 기존 서버에 연결만 하면 되기 때문에 도입도 간단하다.

MCP 는 다양한 AI 에이전트와 통합 가능하다.

- Amazon Q Developer CLI

- Claude Desktop, CLI

- LlamaIndex

- Strands Agents

- LangGraph

또한 MCP 서버는 다음과 같은 두 가지 프로토콜을 통해 통신한다.

STDIO

가장 기본적인 전송 방식으로, 보통 로컬에서 MCP 서버를 실행할 때 사용된다.

서버와 클라이언트가 같은 시스템 내에서 표준 입출력(Standard input/output)를 통해 통신한다.

Claude Desktop, Amazon Q CLI, 로컬 테스트 환경 등에 적합하다.

즉 방식은 로컬 전용이며, 여러 사용자가 동시에 접속하는 다중 사용자 환경을 지원하기 어렵고 토큰 기반 인증이나 방화벽, 프록시 같은 웹 인프라와 호환되지 않는다.

Streamable HTTP

HTTP 프로토콜을 기반으로 MCP 서버를 실행하는 방식이다.

웹 기반 배포에 가장 적합하며, 공식 문서에서도 사용을 권장한다.

보통 운영환경에서 사용되며, stdio가 작업이 모두 끝난 후에야 결과를 한 번에 보여주는 반면,

이 방식은 결과가 생성되는 대로 조금씩 나누어 실시간으로 보여준다.

전체 요약이 끝날 때까지 기다리는 것이 아니라, 요약된 문장이 하나씩 화면에 나타나기 때문에 사용자는 응답이 훨씬 빠르고 자연스럽다고 느낀다.

2. 적용 가능성과 적용시 이점

먼저 아래와 같이 PoC 를 진행함으로서 실제 업무에 적용 가능성을 확인해보려고 한다.

- 로컬에서 Spark History Server를 실행 및 여러 spark job을 제출한다.

- Spark History Server를 바라보는 MCP 서버를 구성하고 이를 Claude CLI와 연동한다.

- slow query, out of memory, data skew, shuffle 병목 등 여러 문제가 발생하는 job을 구성하여 제출 후 Claude CLI를 통해 문제 분석 및 해결책을 도출한다.

- 문제 분석 및 도출된 솔루션을 팀 내에서 리뷰를 진행하여 적용 가능성을 확인한다.

적용 후 예상되는 이점은 아래와 같다.

장애 복구 시간(Mean Time to Recovery) 단축- Claude CLI에서 자연어로 원인 파악 및 해결책 도출

- “Jop spark-xxx 이 왜 OOM이 발생했냐?”

- “Stage 2에서 Task 간 실행 시간 편차가 큰 이유는?”

- “어제 같은 ETL Job과 비교해서 오늘 성능이 저하된 원인은?”

- Claude CLI에서 자연어로 원인 파악 및 해결책 도출

주기적으로 ETL 성능 리포트 작성하여 확인 필요한 job에 대해서는 slack 알람 전송- 전일 대비 성능 저하된 Job

- 처리량에 비해 리소스(cpu, memory 등) 과다 할당 Job (확인 가능하다면 Cost Saving 가능)

- OOM, Data Skew 등 문제가 있는 Job

- 가장 느린 Job 상위 5개 선별

팀 내부 지식베이스 구축- 자주 발생하는 문제 및 해결책을 바탕으로 팀 위키 작성

위 PoC가 성공적으로 검증 되었다면 업무에 실제 도입하기 위해 로컬 환경이 아닌 MCP 서버를 클러스터에 구성하고 ai agent 도입을 통해 서버에서 필요한 데이터를 가져온 후 가공 및 slack 으로 정보를 요약하여 전달할 수 있도록 할 예정이다.

3. Local Testing Guide

3-1) Prerequisites

- Install Claude CLI or Desktop

- Docker must be running (for Spark History Server)

- Python 3.12+ with uv package manager

3-2) Setup environment

mkdir spark-mcp-demo

cd spark-mcp-demo

git clone https://github.com/kubeflow/mcp-apache-spark-history-server.git

cd mcp-apache-spark-history-server

# Install Python uv

curl -LsSf https://astral.sh/uv/install.sh | sh

# vi ./zshrc 환경 변수 추가

export PATH=$HOME/.local/bin:$PATH

# Install node (for MCP Inspector)

brew install node

# Install Spark 3.5.5

# -f: fail on HTTP erros

# -L: redirect를 통해 자동으로 따라가서 진짜 아카이브를 받아온다.

curl -fL -o spark-3.5.5-bin-hadoop3.tgz \

https://dlcdn.apache.org/spark/spark-3.5.5/spark-3.5.5-bin-hadoop3.tgz

tar -xzf spark-3.5.5-bin-hadoop3.tgz

ln -s spark-3.5.5-bin-hadoop3 spark

spark 설치를 완료 한 후 spark history server 실행 및 spark-submit을 자유롭게 진행하기 위해 아래와 같이 환경 변수를 줄 수도 있다.

# Spark environment (.zshrc)

export SPARK_HOME="$HOME/dev/spark-mcp-demo/spark"

export PATH="$SPARK_HOME/bin:$SPARK_HOME/sbin:$PATH"

그 후 로컬에서 Spark History Server 의 데이터를 저장할 경로와 권한을 추가해준다.

# for spark history events dir

mkdir -p /tmp/spark-events

chmod 755 /tmp/spark-events

spark 실행시 config 파일은 아래와 같이 추가해준다.

# Spark History Server Config

vi $SPARK_HOME/conf/spark-defaults.conf

# Event Log 설정

spark.eventLog.enabled=true

spark.eventLog.dir=file:///tmp/spark-events

# History Server 설정

spark.history.fs.logDirectory=file:///tmp/spark-events

spark.history.ui.port=18080

마지막으로 MCP 서버의 config 파일을 작성해주자.

mcp-apache-spark-history-server 디렉토리 내에 config.yaml 을 수정하거나,

파일이 없다면 새로운 파일로 생성해주면 된다.

servers:

local:

default: true

url: "http://localhost:18080"

mcp:

transports:

- stdio

port: "18888"

debug: true

address: localhost

3-3) Check installation

정상적으로 모두 설치가 되어 있는지 확인해보자.

java --version

spark-shell --version

uv --version

task --version # Optional

node --version # Optional

3-4) Test spark-submit

Spark History Server를 실행해보자.

# in spark dir

# http://localhost:18080

$SPARK_HOME/sbin/start-history-server.sh

그 후 test 할 spark 코드를 작성하여 spark-submit을 해보자.

vi test_normal.py

from pyspark.sql import SparkSession

from pyspark.sql.functions import *

spark = SparkSession.builder \

.appName("TestNormalJob") \

.config("spark.eventLog.enabled", "true") \

.config("spark.eventLog.dir", "file:///tmp/spark-events") \

.getOrCreate()

# 간단한 데이터 처리

data = [(i, f"user_{i}", i * 10) for i in range(1000)]

df = spark.createDataFrame(data, ["id", "name", "value"])

result = df.groupBy("name").agg(

avg("value").alias("avg_value"),

count("*").alias("count")

)

print(f"처리 완료")

spark.stop()

환경변수를 지정했다면 spark-submit 명령어만 입력하여 파이썬 파일을 제출할 수 있다.

$SPARK_HOME/bin/spark-submit test_normal.py

3-4) Claude Desktop

Claude Desktop 를 참고하여 설정하면 되며, 아래와 같이 claude desktop 전용 설정 파일에 추가해주어야 한다.

vi ~/Library/Application\ Support/Claude/claude_desktop_config.json

{

"mcpServers": {

"mcp-apache-spark-history-server": {

"command": "/Users/jang-won-yong/.local/bin/uvx",

"args": [

"--from",

"mcp-apache-spark-history-server",

"spark-mcp",

"--config",

"/Users/jang-won-yong/dev/spark-mcp-demo/mcp-apache-spark-history-server/config.yaml"

],

"env": {

"SHS_MCP_TRANSPORT": "stdio",

"SHS_MCP_DEBUG": "true"

}

}

}

}

3-5) Claude CLI

Claude Dekstop 외에도 CLI를 통해서 MCP를 연동할 수 있으며, config 파일은 절대 경로로 입력해주자.

claude mcp add spark-history -s user -- \

uvx --from mcp-apache-spark-history-server spark-mcp \

--config /Users/jang-won-yong/dev/spark-mcp-demo/mcp-apache-spark-history-server/config.yaml

위와 같이 MCP 서버를 등록하게 되면 ~/.claude.json 에 추가된 것을 확인할 수 있으며, 아래 명령을 통해 등록된 서버를 확인할 수 있다.

# 등록 서버 목록

claude mcp list

# 해당 서버 상세

claude mcp get spark-history

# 해당 서버 삭제

claude mcp remove spark-history

Claude에서 발생하는 로그는 아래 경로에서 확인할 수 있으며, 설정 과정에서 문제가 발생하면 해당 에러로그를 살펴봐야 한다.

# Claude log

cd ~/Library/Logs/Claude

4. Proof of Concept

Claude CLI를 통해서 제출된 Spark 어플리케이션을 조회하여 MCP 연동이 되었는지 확인해보고 여러 케이스에 대해서 문제 분석과 적절한 해결책을 도출해주는지 확인해보자.

4-1) 정상적인 Job

먼저 Claude CLI 를 이용하여 Spark History Server에 제출된 어플리케이션들을 아래와 같이 조회할 수 있다.

> Spark History Server에서 어플리케이션들을 조회해줘.

⏺ Spark History Server에서 애플리케이션 목록을 조회하겠습니다.

⎿ {

"id": "local-1760161598647",

"name": "TestNormalJob",

… +17 lines (ctrl+o to expand)

⏺ Spark History Server에 등록된 애플리케이션 목록입니다:

애플리케이션 정보

Application ID: local-1760161598647이름: TestNormalJob사용자: jang-won-yongSpark 버전: 3.5.5

실행 정보:

- 시작 시간: 2025-10-11 05:46:37 (GMT)

- 종료 시간: 2025-10-11 05:46:44 (GMT)

- 실행 시간: 6.9초

- 상태: 완료됨

현재 1개의 완료된 애플리케이션이 조회되었습니다. 이 애플리케이션에 대해 더 자세한 정보(jobs,

stages, executors 등)를 확인하시겠습니까?

MCP 서버에서 제공하는 list_applications 를 이용하여 현재 어플리케이션들을 조회한 것을 확인할 수 있다.

조회된 어플리케이션을 자세히 분석해달라는 요청을 하게 되면 여러 방면으로 분석 후 현재 문제점과 각 솔루션을 제시해주게 된다.

마지막으로 mcp 서버를 이용한 분석시 Time Out, OOM 등의 문제가 발생한다면 TROUBLESHOOTING를 참고하자.

5. 정리

MCP 를 활용하여 Spark 어플리케이션 문제 분석을 했을 때 PoC의 결과는 성공적이였다.

MCP 활용시 장점 중 하나는 disk spill 이나 data skew 등의 이슈가 어느정도 발생 하는지와

어느 stage에서 발생 하는지에 대한 정보를 빠르게 확인할 수 있다는 것이다.

즉, 병목에 가장 문제가 되는 구간을 우선순위별로 정리 하여 솔루션을 제시해 줄 수 있게 된다.

기존 Spark History Server UI에서는 각 stage 마다 클릭해가며 메트릭을 확인해야 했다.

물론 전달받은 솔루션이 모두 정답은 아니며, 좋은 답변을 해주지 않을 수도 있다.

하지만, 좋은 답변을 얻으려면 구체적이고 명확한 프롬프트가 필수적이기 때문에

ai agent를 이용한 구체적인 프롬프트를 추가할 예정이다.

마지막으로 우리가 실무에서 얻은 방대한 Spark 튜닝 지식과 히스토리를 매번 프롬프트에 무한정 추가하는

것은 불가능하다.

토큰 제한(Context Window)이 있을 뿐더러 비효율적이기 때문이다.

따라서 휘발되는 지식을 외부 메모리(Vector DB)로 구조화하여 AI가 언제든 꺼내 쓸 수 있는 지식 베이스로

만들어야 할 것이다.

AI에게 질문을 할 때마다 매번 Reset 상태로 분석을 시작한다.

DataFrame Write 단계와 UDF 실행 시에는 On-heap 이 아닌 Off-heap 메모리를 집중적으로 사용한다 라는 중요한 기술적 맥락을 매번 새로 설명하지 않으면 AI는 겉핥기 식 답변만 내놓게 될 것이다.

Reference

https://github.com/kubeflow/mcp-apache-spark-history-server

https://blog.a-cloud.co.kr/2025/07/24/ai%EB%A1%9C-apache-spark-%EB%94%94%EB%B2%84%EA%B9%85-%EC%9E%90%EB%8F%99%ED%99%94%ED%95%98%EB%8A%94-mcp-%EC%84%9C%EB%B2%84-%EC%86%8C%EA%B0%9C/

https://aws.amazon.com/ko/blogs/big-data/introducing-mcp-server-for-apache-spark-history-server-for-ai-powered-debugging-and-optimization/